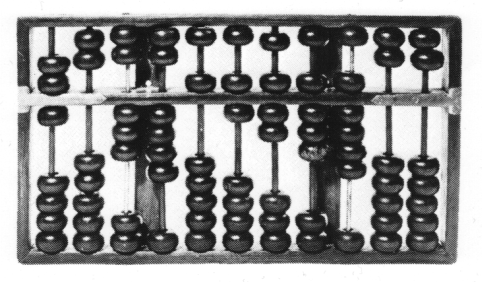

Zu den ältesten Rechenhilfsmitteln gehört ein einfaches Gerät namens "Abakus": es besteht im wesentlichen aus einer Reihe parallel angeordneter Stäbe, auf denen verschiebbare Perlen bzw. Kugeln sitzen. Der Abakus erleichtert vor allem die Addition und die Subtraktion, indem er in der Stellung der Kugeln die gerade bearbeiteten Zahlen "speichern" kann. Er kann zwar auch zur Multiplikation (oder gar zur Division) eingesetzt werden; allerdings muss der Benutzer dazu die benötigten Algorithmen kennen, und die sind nicht gerade selbsterklärend. So sind die "Strichrechungen" dann doch die eigentliche Domäne des Abakus geblieben. Das Gerät war schon in der Antike bekannt und wurde über lange Zeiten im kaufmännischen Bereich als Standard-Hilfsmittel eingesetzt. Man schätzt, dass noch heute etwa die Hälfte der Menschen auf unserer Erde verschiedene Varianten des Abakus in ihrem täglichen Leben einsetzen! |

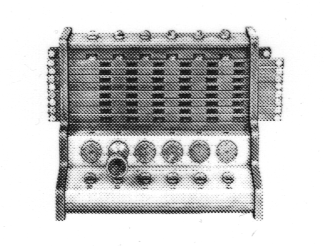

Spätestens seit der Einführung der naturwissenschaftlichen Arbeitsweise durch Galilei gab es einen größeren Bedarf an leistungsfähigeren Rechenhilfsmitteln. Der Traum von einer "universellen Rechenmaschine" beflügelte viele findige Köpfe und führte zu erstaunlichen Geräten. So konstruierte schon 1623 der Tübinger Professor der Mathematik und Astronomie Wilhelm Schickhard eine Rechenmaschine, die die Addition und Subtraktion zweier (bis zu) sechsstelliger Zahlen beherrschte. Sie bestand im Wesentlichen aus Zahnrädern, deren Stellungen die Dezimalstellen der zu bearbeitenden Zahlen kodierten. Schickhard verkoppelte die Zahnräder so geschickt zu einem Getriebe, dass durch eine Kurbeldrehung eine Addition bzw. Subtraktion durchgeführt werden konnte, bei der es sogar schon einen automatischen Zehnerübertrag gab! Für die Multiplikation (und die Division) baute er keinen eigentlichen Rechenmechanismus ein, sondern nur eine Hilfe durch sogenannte "Napier'sche Stäbchen": diese erlaubten (unter Ausnutzung der damals neuesten mathematischen Forschungsergebnisse) die Multiplikation durch eine Addition zu "ersetzen" - aber um das zu verstehen, musste der Benutzer schon ein ausgewachsener Mathematiker sein. |

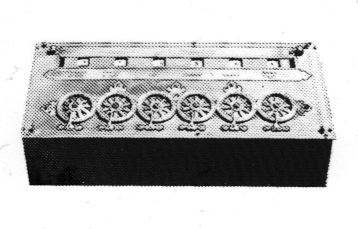

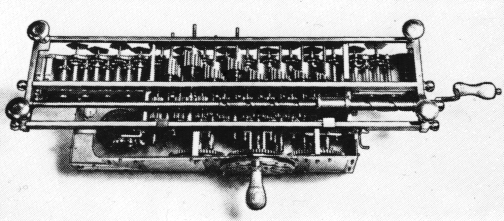

Eine ähnlich arbeitende Maschine, die sich aber auf die reine Addition beschränkte, wurde 1645 vom jungen Blaise Pascal für seinen Vater entwickelt, um dessen Arbeit als Steuerbeamter zu erleichtern. Das Bild links zeigt die Maschine als Ganzes; rechts ist ein Ausschnitt aus der Mechanik der Maschine dargestellt. Die "Pascaline" soll tatsächlich einigermaßen zuverlässig gearbeitet haben. Einige Probleme mit der Mechanik musste man aber bei all diesen frühen Rechenmaschinen in Kauf nehmen - die Feinmechanik steckte in diesen finsteren Zeiten noch in den Kinderschuhen! Pascals Rechenmaschine galt lange Zeit als die erste mechanische Rechenmaschine überhaupt, bis die Wissenschaftshistoriker die Konstruktionsunterlagen der zuvor genannten Schickhard'sche Rechenmaschine wiederentdeckten. |

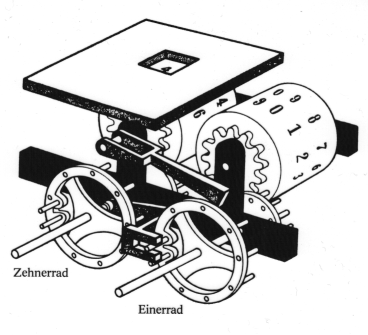

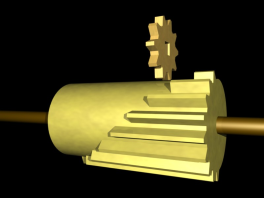

Das eigentliche Ziel war jedoch eine "Vier-Spezies-Maschine", also eine Rechenmaschine, die die vier Grundrechenarten beherrschte. Gottfried Wilhelm Leibniz veröffentlichte 1672 zumindest ein vollständiges und schlüssiges Konzept für den Bau einer solchen Maschine. Das zentrale Funktionselement war die links dargestellte "Staffelwalze": je nach horizontaler Stellung des Zahnrades über der Walze wurde dieses durch eine vollständige Umdrehung der Walze gar nicht oder um eine, zwei, drei,.... oder neun Zehntel-Umdrehungen weitergedreht. Damit realisierte Leibniz die Addition und (durch Umkehrung der Drehrichtung) die Subtraktion. Zur Realisierung der Multiplikation installierte er zwei Zählwerke, "pars immobilis" und "pars mobilis" genannt. In der Abbildung ist das "pars immobilis" die untere feststehende Basis, die das Ergebnis e der Multiplikation e = a * b aufzunehmen hatte. Im "pars mobilis", welches sich in horizontaler Richtung verschiebbar oberhalb des Ergebnis-Speichers befand, wurde die dezimale Darstellung des ersten Faktors a abgelegt.

Das eigentliche Ziel war jedoch eine "Vier-Spezies-Maschine", also eine Rechenmaschine, die die vier Grundrechenarten beherrschte. Gottfried Wilhelm Leibniz veröffentlichte 1672 zumindest ein vollständiges und schlüssiges Konzept für den Bau einer solchen Maschine. Das zentrale Funktionselement war die links dargestellte "Staffelwalze": je nach horizontaler Stellung des Zahnrades über der Walze wurde dieses durch eine vollständige Umdrehung der Walze gar nicht oder um eine, zwei, drei,.... oder neun Zehntel-Umdrehungen weitergedreht. Damit realisierte Leibniz die Addition und (durch Umkehrung der Drehrichtung) die Subtraktion. Zur Realisierung der Multiplikation installierte er zwei Zählwerke, "pars immobilis" und "pars mobilis" genannt. In der Abbildung ist das "pars immobilis" die untere feststehende Basis, die das Ergebnis e der Multiplikation e = a * b aufzunehmen hatte. Im "pars mobilis", welches sich in horizontaler Richtung verschiebbar oberhalb des Ergebnis-Speichers befand, wurde die dezimale Darstellung des ersten Faktors a abgelegt. Um die Wirkungsweise des Multiplikations-Mechanismus zu illustrieren, betrachten wir die konkrete Multiplikation, z.B.

Um die Wirkungsweise des Multiplikations-Mechanismus zu illustrieren, betrachten wir die konkrete Multiplikation, z.B. Leider kam Leibniz nie in den Genuss, seine Maschine auch wirklich benutzen zu können: die Feinmechaniker seiner Zeit waren von den Anforderungen dieser Mechanik hoffnungslos überfordert und konnten ihm die gewünschte Maschine nicht bauen! Zwar investierte Leibniz eine Menge Geld in das Projekt, ohne jedoch jemals ein vorzeigbares Ergebnis zu erhalten. Der erste wirklich fehlerfrei und zuverlässig arbeitende Nachbau einer Leibniz'schen Rechenmaschine stammt von 1990(!). Im Heinz-Nixdorf-Computermuseum in Paderborn kann man inzwischen ein tadellos funktionierendes Exemplar dieser Maschine bewundern. Die Verdienste von Leibniz erschöpfen sich jedoch nicht im Entwurf einer (zu seiner Zeit) nicht realisierbaren Rechenmaschine. Viel wichtiger für die Kulturgeschichte der Menschheit waren die theoretischen Überlegungen, die er im Rahmen dieses Projekts anstellte. So führten ihn die unschönen Erfahrungen mit der unzureichenden Mechanik zu einer Notiz in seinen Aufzeichnungen, dass für den Bau einer Rechenmaschine möglicherweise das Zweiersystems geeigneter sein könnte als das Zehnersystem. Diese Idee schlummerte dann aber mehrere hundert Jahre unentdeckt vor sich hin. Erst Konrad Zuse setzte sie in seinen Maschinen in die Tat um! |

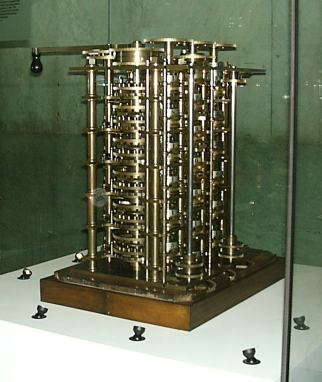

Ein ähnlich trauriges Schicksal wie die Leibniz'sche Rechenmaschine hatte die "Difference engine", die Charles Babbage von 1812 bis 1832 entwickelte. Ein erstes Arbeitsmodell gab Anlass zu kühnen Hoffnungen, aber der Entwurf der vollständigen Maschine konnte mit der Feinmechanik des 19. Jahrhunderts noch nicht realisiert werden: 25 Zahnräder hätten ineinander greifen müssen, ohne sich zu verklemmen - unmöglich für die damalige Zeit! Das Bild links zeigt einen modernen Nachbau der "Difference engine", der im "Science museum" in London steht. Dieser Nachbau ist voll funktionsfähig: die "Difference engine" sollte zur Überprüfung von mathematischen Tabellen dienen, und tatsächlich kann der Nachbau sämtliche dafür nötigen Berechnungen korrekt durchführen. Nachträglich wird damit also die Korrektheit des Entwurfs von Charles Babbage gezeigt!

Ein ähnlich trauriges Schicksal wie die Leibniz'sche Rechenmaschine hatte die "Difference engine", die Charles Babbage von 1812 bis 1832 entwickelte. Ein erstes Arbeitsmodell gab Anlass zu kühnen Hoffnungen, aber der Entwurf der vollständigen Maschine konnte mit der Feinmechanik des 19. Jahrhunderts noch nicht realisiert werden: 25 Zahnräder hätten ineinander greifen müssen, ohne sich zu verklemmen - unmöglich für die damalige Zeit! Das Bild links zeigt einen modernen Nachbau der "Difference engine", der im "Science museum" in London steht. Dieser Nachbau ist voll funktionsfähig: die "Difference engine" sollte zur Überprüfung von mathematischen Tabellen dienen, und tatsächlich kann der Nachbau sämtliche dafür nötigen Berechnungen korrekt durchführen. Nachträglich wird damit also die Korrektheit des Entwurfs von Charles Babbage gezeigt!Ungeachtet der unüberwindbaren Schwierigkeiten bei der Realisierung der "Diffence engine" entwarf Babbage bereits im Jahr 1833 die "Analytical engine": diese gilt als die erste programm-gesteuerte Maschine für allgemeine mathematische Berechnungen. Da diese neue "Analytical engine" noch um einiges komplizierter als die alte "Difference engine" war, konnte sie natürlich ebenfalls nicht erfolgreich gebaut werden. Trotzdem wurden schon damals erste Programme für die "Analytical engine" geschrieben: eine Mitarbeiterin von Charles Babbage, nämlich Miss Ada Lovelace, entwickelte z.B. ein Programm, mit dem sie die Folge der Bernoulli-Zahlen hätte berechnen können, wenn es denn damals schon eine lauffähige "Analytical engine" gegeben hätte... Immerhin gilt Ada Lovelace seitdem als die erste Programmiererin der Welt, und ihr zu Ehren wurde eine heute noch wichtige Programmiersprache "Ada" getauft! |

Babbage hatte vorgesehen, dass das "Programm" der Analytical engine auf Lochkarten kodiert werden sollte. Damit griff er zurück auf eine bewährte Technik, die von Joseph-Marie Jacquard schon zu Beginn des 19. Jahrhunderts entwickelt worden war. Jacquard konstruierte damals einen vollautomatischen Webstuhl, bei dem er zur Steuerung des zu webenden Musters Lochkarten einsetzte: je nachdem, ob an einer bestimmten Stelle einer solchen Karte ein Loch war oder nicht, wurde die Führung der Schussfäden modifiziert oder nicht. Jacquard gilt damit als der eigentliche Erfinder des ersten digitalen Datenträgers. Die Lochkarten erlaubten nahezu beliebig komplizierte Muster von zuvor nicht gekannter Größe und Komplexität. Durch die Fortschritte bei der Mechanisierung der Webereien gingen allerdings auch Tausende von Arbeitsplätzen verloren: was zuvor durch viele menschliche Arbeitskräfte geleistet worden war, wurde nun von einem Automaten erledigt, und zwar präziser, schneller und billiger -- eine bittere Erkenntnis für die betroffenen Weber!

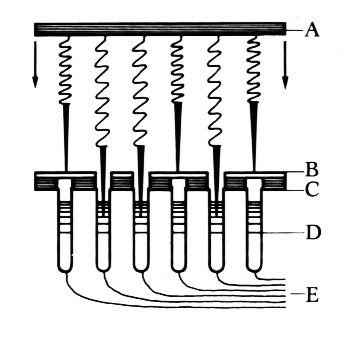

Der Siegeszug der Lochkarte war jedoch nicht aufzuhalten. Der nächste spektakuläre Einsatz dieses neuen Mediums ging unter der Federführung von Hermann Hollerith im Jahre 1890 über die Bühne: zur Auswertung der 11. amerikanischen Volkszählung entwickelte und konstruierte er Lochkarten-gesteuerte Zähl- und Auswerte-Maschinen sowie die zugehörigen Kodierungsgeräte, mit denen die Daten in die Lochkarten gestanzt wurden.

Der Siegeszug der Lochkarte war jedoch nicht aufzuhalten. Der nächste spektakuläre Einsatz dieses neuen Mediums ging unter der Federführung von Hermann Hollerith im Jahre 1890 über die Bühne: zur Auswertung der 11. amerikanischen Volkszählung entwickelte und konstruierte er Lochkarten-gesteuerte Zähl- und Auswerte-Maschinen sowie die zugehörigen Kodierungsgeräte, mit denen die Daten in die Lochkarten gestanzt wurden.Beim Auslesen der auf den Lochkarten gespeicherten Daten entschied die Lochkarte darüber, ob ein entsprechender Stromkreis geschlossen wurde oder nicht: nur wenn an der entsprechenden Stelle ein Loch war, konnte eine Metallnadel durch die Lochkarte hindurch in einen mit Quecksilber(!) gefüllten Behälter eintauchen. Damit wurde ein elektrischer Stromkreis geschlossen, welcher den Zählerstand einer Zähluhr um Eins erhöhte. Mit Hilfe dieser Maschinen (und dem minutiösen Management von Hollerith!) konnte die Volkszählung nahezu unglaublich schnell abgeschlossen werden: was 10 Jahre zuvor noch 500 Helfer für fast 7 Jahre beschäftigt hatte, konnte Hollerith mit 43 Zählmaschinen und ebenso viel Bedienungspersonal in knapp 4 Wochen erledigen! Hollerith hatte die von ihm entwickelte Apparatur schon vor der Durchführung der Volkszählung patentieren lassen. In den folgenden Jahren verbuchte er so großen wirtschaftlichen Erfolg, dass er 1996 eine eigene Firma gründete, die "Tabulating Machine Company". Der Erfolg hielt zunächst an; später verlor er allerdings mehrere seiner Grosskunden, weil diese wegen seiner überhöhten Preise lieber zur schnell wachsenden Konkurrenz gingen. In der Folge verstrickte sich Hollerith in juristische Auseinandersetzungen mit diesen Konkurrenten; die daraus resultierenden Prozesse kosteten Kraft und Geld und führten meist nicht zum gewünschten Ergebnis. Zermürbt verkaufte er schließlich seine Firma und begnügte sich mit einem wohldotierten Beratervertrag. Nach einigen Fusionen mit anderen Betrieben ging die Firma schließlich in der "International Business Machine Corporation" auf, welche noch heute unter dem Kurznamen "IBM" tätig ist! Die legendäre Schnelligkeit der Maschinen des Hermann Hollerith fand ihre Würdigung in einer deutschen Redewendung, die unseren Großeltern noch recht geläufig gewesen war: wenn ein Vorgang flott vonstatten ging, sagte man damals: "Das geht ja wie bei einer Hollerith-Maschine!" |

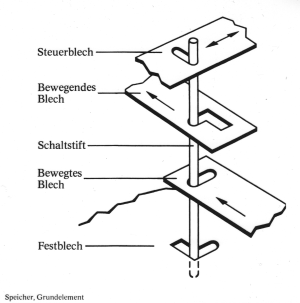

Die Vision, die Charles Babbage in seinem Entwurf der "Analytical engine" niederschrieb, wurde von Konrad Zuse 1936 in seiner "Z1" verwirklicht: Zuse baute in seiner Heimatstadt Berlin eine programmierbare Maschine, die allgemeine mathematische Berechnungen ausführen sollte. Die "Z1" wurde über Lochstreifen programmiert: dazu nahm Zuse alte Filmrollen aus Tonfilm-Studios und stanzte die passenden Löcher hinein. Das eigentlichen Rechenwerk war jedoch voll-mechanisch: die Maschine bestand aus etwa

Die Vision, die Charles Babbage in seinem Entwurf der "Analytical engine" niederschrieb, wurde von Konrad Zuse 1936 in seiner "Z1" verwirklicht: Zuse baute in seiner Heimatstadt Berlin eine programmierbare Maschine, die allgemeine mathematische Berechnungen ausführen sollte. Die "Z1" wurde über Lochstreifen programmiert: dazu nahm Zuse alte Filmrollen aus Tonfilm-Studios und stanzte die passenden Löcher hinein. Das eigentlichen Rechenwerk war jedoch voll-mechanisch: die Maschine bestand aus etwa

|

Die nächste in der Serie der Maschinen von Konrad Zuse war die Z3, welche im Wesentlichen eine in Relais-Technik realisierte Variante der mechanischen Z1 war. Selbst die Speichergrößen der beiden Rechner stimmten überein. Und die Beschränkungen waren ebenfalls dieselben: beide Rechner konnten lediglich lineare, also unverzweigte Programme abarbeiten, und beide verfügten noch nicht über bedingte Sprünge und Schleifen. Nur die Technologie wurde komplett geändert: statt der 30 000 Bleche in der Z1 rechneten in der Z3 nun etwa 2600 Telephonrelais...

Die nächste in der Serie der Maschinen von Konrad Zuse war die Z3, welche im Wesentlichen eine in Relais-Technik realisierte Variante der mechanischen Z1 war. Selbst die Speichergrößen der beiden Rechner stimmten überein. Und die Beschränkungen waren ebenfalls dieselben: beide Rechner konnten lediglich lineare, also unverzweigte Programme abarbeiten, und beide verfügten noch nicht über bedingte Sprünge und Schleifen. Nur die Technologie wurde komplett geändert: statt der 30 000 Bleche in der Z1 rechneten in der Z3 nun etwa 2600 Telephonrelais...Sowohl die Z3 als auch die Z1 und die Z2 wurden im Dezember 1943 bei einem Bombenangriff der Alliierten auf Berlin zerstört. Das nächste Modell Z4 transportierte Zuse selbst in den letzten Wochen des 2. Weltkriegs unter abenteuerlichen Umständen aus Berlin heraus und quer durch Deutschland in einen kleinen Ort bei Kempten im Allgäu. Schließlich konnte er im Jahr 1949 diesen aus Berlin geretteten Z4-Rechner an die ETH Zürich verleihen, womit wegen der nun regelmäßig eintreffenden Mietzahlungen die Produktion weiterer Geräte ein finanzielles Fundament erhielt. Das eigentliche Ziel von Zuse war nämlich stets die Herstellung von Rechenmaschinen in Großserie gewesen. Er selbst betrachtete die Z1, Z2 und Z3 als Prototypen, die Z4 hingegen als die erste serientaugliche Maschine. Folgerichtig gründete er noch 1949 die ZUSE KG, mit der er dann in die Serienfertigung einstieg. Die Firma produzierte bis in die Mitte der 60er Jahre eine große Palette an Rechenmaschinen, entwickelte aber auch neuartige Peripheriegeräte, wie z.B. mit dem "Graphomat Z64" den ersten Plotter oder mit dem "Haromat" das erste Digitalisiertablett! |

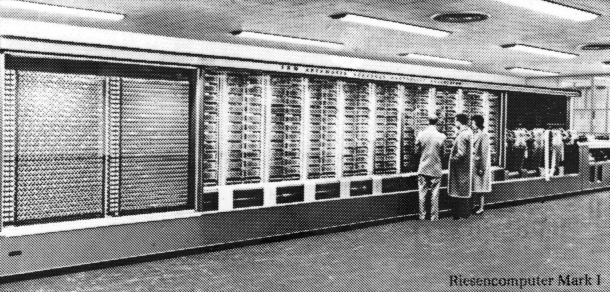

Soweit die Computergeschichte aus einem deutschen Blickwinkel. Der Rest der Welt hat jedoch den Anbruch des Computerzeitalters ebenfalls nicht verschlafen: im Gegenteil! Während es in Deutschland sowohl an den Universitäten als auch in der Wirtschaft allenthalben an Interesse und Sachverstand für die neue Informationstechnologie mangelte und die Forschung über diesen neuen Gegenstand in den Händen einiger weniger ambitionierter Privatleute lag, stürzten sich in den USA ganze Scharen von Universitätslehrern auf das neue Thema, und die öffentliche Hand förderte bereitwillig selbst ziemlich teure Großprojekte - Hauptsache es ging voran mit den Rechenmaschinen!  So konnte z.B. Prof. Howard H. Aiken von der Harvard-Universität in Cambridge, Massachusetts im Jahre 1944 einen wahren Rechenkoloss in Betrieb nehmen: Mark I hatte eine 15 m lange und weit über 2 m hohe Frontfläche, hinter der etwa

So konnte z.B. Prof. Howard H. Aiken von der Harvard-Universität in Cambridge, Massachusetts im Jahre 1944 einen wahren Rechenkoloss in Betrieb nehmen: Mark I hatte eine 15 m lange und weit über 2 m hohe Frontfläche, hinter der etwa Dem Modell Mark I folgten in den Jahren danach die Modelle Mark II, III und IV. Auch hier wurden (wie bei Herrn Zuse) die mechanischen Teile des Rechenwerks aufgegeben zugunsten elektrischer und schließlich elektronischer Design-Varianten. So rechnete Mark IV mit Elektronenröhren; Daten konnten im einem magnetischen Trommelspeicher zwischengelagert werden; der eigentliche Hauptspeicher, in dem die Rechnungen ausgeführt wurden, bestand aus 200 Registern, in denen die Bits in kleinen ringförmigen Magnetkernen gespeichert wurden: die Orientierung des gespeicherten Magnetfeldes entschied darüber, ob das Bit den Wert "0" oder "1" haben sollte. Alle Rechenmaschinen dieser Serie blieben jedoch bewusst bei der strikten Trennung von Programm und Daten; diese Design-Entscheidung wurde in der Folgezeit mit dem Namen "Harvard-Architektur" belegt. Auch wenn beim Mark IV das Programm ebenfalls von einem Trommelspeicher eingelesen wurde, war es zur Laufzeit doch statisch. |

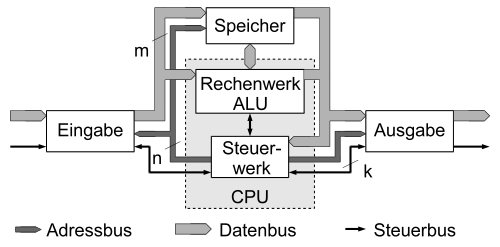

Wiederhole

Hole den nächsten Programmbefehl aus dem RAM in die CPU.

Führe den Befehl aus.

bis das Programm-Ende erreicht ist.

Diese Schleife nennt man den "von-Neumann-Zyklus". Der erste Computer, der nach diesem Prinzip arbeitete, war - zumindest aus amerikanischen Blickwinkel - der 1946 an der Universität von Pennsylvania in Betrieb genommene ENIAC ("Electronic Numerical Integrator And Computer"), an dessen Entwicklung John von Neumann wesentlich beteiligt war. Wie oben schon beschrieben, stellte in Deutschland etwa zur gleichen Zeit Konrad Zuse seine "Z4" fertig, welche ebenfalls ein "von-Neumann-Rechner" war.